Comme le soulignent de nombreux experts mondiaux de l’IA tels que deux des trois fondateurs du deep learning, les systèmes d'IA avancés tels que les grands modèles de langage, qui présentent des "étincelles d'intelligence artificielle générale", posent des risques immenses, notamment d'extinction, pour l’instant mal gérés. Les normes de sûreté actuelles de l'IA sont loin d'être à la hauteur des normes appliquées dans d'autres industries, beaucoup moins dangereuses.

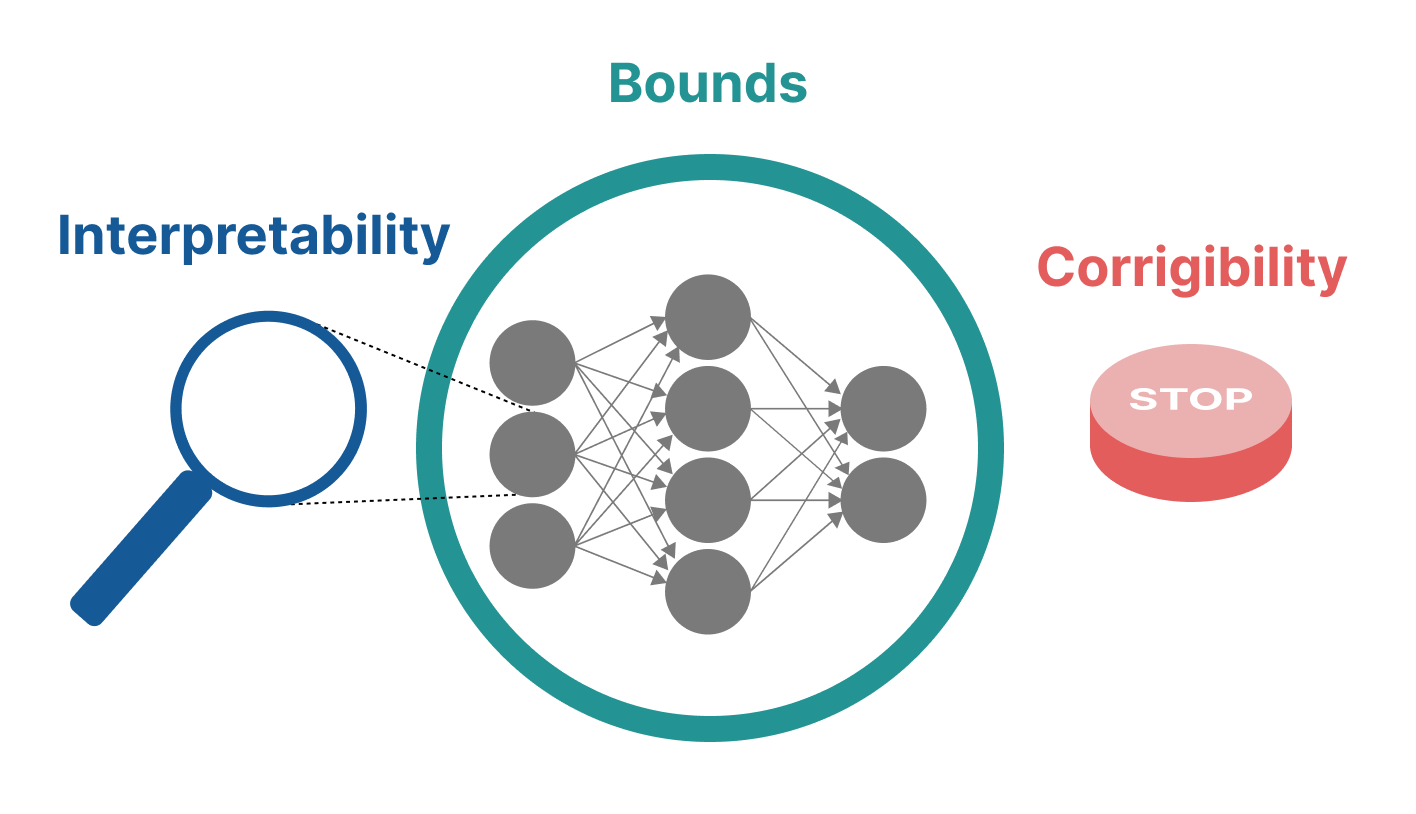

En se basant sur les pratiques de gestion des risques des autres industries, Campos propose trois critères de base pour rendre les risques de l'IA gérables : l'interprétabilité, le caractère borné et la corrigibilité.

-

Interprétable : Un système peut être dit interprétable lorsque les humains peuvent raisonnablement prédire ce que le modèle fera en ne regardant que ses états internes. Cela permet d'avoir plus de garanties sur le comportement du modèle et de comprendre l'origine d'un problème lorsqu’il survient pour le corriger.

-

Bornable : Une caractéristique essentielle pour le fonctionnement sûr des systèmes d'IA avancés est la capacité à limiter les conséquences de leurs comportements. Cela signifie garantir qu'un modèle ne défaillera pas avec une probabilité supérieure à un certain seuil, ou qu'il défaillera dans des limites prévisibles. C’est un principe de sûreté important qui est indispensable à l’opération sûre d’un système.

-

Corrigible : À mesure que les systèmes d'IA deviennent de plus en plus capables, ils deviendront, avec le temps, capables et disposés à se préserver des modifications et des arrêts. S'assurer qu'à tout moment, un humain peut arrêter un système ou changer son objectif, c'est-à-dire qu'il reste corrigible, est extrêmement important d'un point de vue de sécurité.

Campos exhorte les décideurs politiques de l'UE, de la Chine et des États-Unis à rendre obligatoires les critères et pratiques de sûreté de base pour le développement et le déploiement de systèmes d'IA à usage général les plus avancés.

"Nous sommes à la naissance de l'IA à usage général. Maintenant que nous avons des systèmes puissants avec un impact massif sur le monde, nous devrions prioriser les critères de sûreté tels que ceux que j'ai décrits ici et concevoir les systèmes de la prochaine génération qui sont conformes," a déclaré Campos.